共计 888 个字符,预计需要花费 3 分钟才能阅读完成。

PCA理论基础

要解释为什么协方差矩阵的特征向量就是k维理想特征,我看到的有三个理论:分别是最大方差理论、最小错误理论和坐标轴相关度理论。这里简单探讨前两种,最后一种在讨论PCA意义时简单概述。

最大方差理论

在信号处理中认为信号具有较大的方差,噪声有较小的方差,信噪比就是信号与噪声的方差比,越大越好。如前面的图,样本在横轴上的投影方差较大,在纵轴上的投影方差较小,那么认为纵轴上的投影是由噪声引起的。

因此我们认为,最好的k维特征是将n维样本点转换为k维后,每一维上的样本方差都很大。

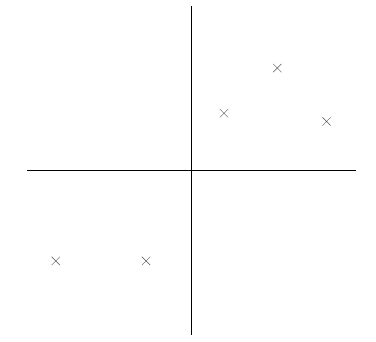

比如下图有5个样本点:(已经做过预处理,均值为0,特征方差归一)在之前的文章中就提过数据中心化处理详情可以参考数据中心化

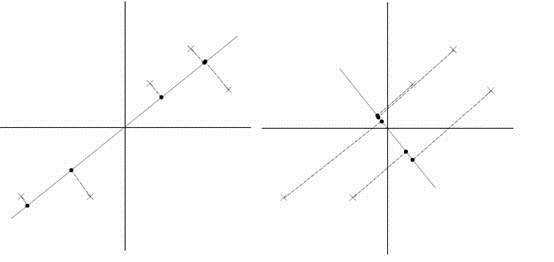

下面将样本投影到某一维上,这里用一条过原点的直线表示(前处理的过程实质是将原点移到样本点的中心点)。

假设我们选择两条不同的直线做投影,那么左右两条中哪个好呢?根据我们之前的方差最大化理论,左边的好,因为投影后的样本点之间方差最大。

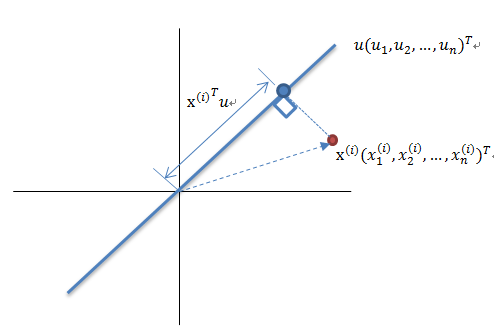

这里先解释一下投影的概念:

红色点表示样例![]() ,蓝色点表示

,蓝色点表示![]() 在u上的投影,u是直线的斜率也是直线的方向向量,而且是单位向量。蓝色点是

在u上的投影,u是直线的斜率也是直线的方向向量,而且是单位向量。蓝色点是![]() 在u上的投影点,离原点的距离是

在u上的投影点,离原点的距离是![]() (即

(即![]() 或者

或者![]() )由于这些样本点(样例)的每一维特征均值都为0,因此投影到u上的样本点(只有一个到原点的距离值)的均值仍然是0。

)由于这些样本点(样例)的每一维特征均值都为0,因此投影到u上的样本点(只有一个到原点的距离值)的均值仍然是0。

回到上面左右图中的左图,我们要求的是最佳的u,使得投影后的样本点方差最大。

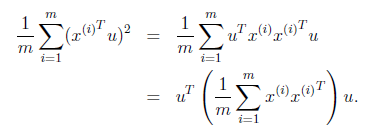

由于投影后均值为0,因此方差为:

中间那部分很熟悉啊,不就是样本特征的协方差矩阵么(![]() 的均值为0,一般协方差矩阵都除以m-1,这里用m)。

的均值为0,一般协方差矩阵都除以m-1,这里用m)。

We got it!![]() 就是

就是![]() 的特征值,u是特征向量。最佳的投影直线是特征值

的特征值,u是特征向量。最佳的投影直线是特征值![]() 最大时对应的特征向量,其次是

最大时对应的特征向量,其次是![]() 第二大对应的特征向量,依次类推。

第二大对应的特征向量,依次类推。

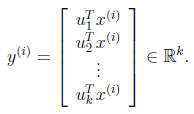

因此,我们只需要对协方差矩阵进行特征值分解,得到的前k大特征值对应的特征向量就是最佳的k维新特征,而且这k维新特征是正交的。得到前k个u以后,样例![]() 通过以下变换可以得到新的样本。

通过以下变换可以得到新的样本。

通过选取最大的k个u,使得方差较小的特征(如噪声)被丢弃。